📖 關於本文

本篇文章基於 MITRE ATLAS AI Security 101(atlas.mitre.org/resources/ai-security-101)的內容進行整理與延伸撰寫,旨在以更易懂的方式向中文讀者介紹 AI 安全的核心概念。如需查閱原始資料或獲取最新資訊,建議前往 MITRE ATLAS 官方網站。

前言:AI 無處不在,威脅也是

從手機的人臉解鎖、電商的推薦系統,到銀行的詐騙偵測、醫療的影像診斷,AI 已經深入我們生活的每個角落。然而,當我們享受 AI 帶來的便利時,攻擊者也正在研究如何利用 AI 的弱點。

傳統的資安防護關注的是「如何保護系統不被入侵」,但 AI 安全面對的問題更加複雜:攻擊者可能不需要入侵你的系統,只需要巧妙地與 AI 互動,就能讓它做出錯誤的決策。

本文將帶你了解 AI 安全的核心概念,認識六種常見的 AI 攻擊手法,並理解如何在 AI 開發生命週期中建立安全防線。

什麼是 AI 安全?

AI 安全(AI Security)是指為了識別和防止威脅與攻擊,保護 AI 模型或 AI 系統的機密性、完整性和可用性,所實施的工具、策略和流程。

換句話說,AI 安全要確保:

– 機密性:AI 模型和訓練資料不被竊取

– 完整性:AI 的判斷結果不被惡意操控

– 可用性:AI 系統能夠正常運作

與傳統資安不同的是,AI 系統引入了全新的威脅向量和漏洞,需要一套專門的安全程序來應對。

理解 AI 攻擊的三個關鍵概念

在深入了解攻擊類型之前,我們需要先認識三個決定攻擊路徑的關鍵概念:

1. AI 存取時間(AI Access Time)

AI 系統的生命週期可分為兩個階段:

| 階段 | 說明 | 攻擊者的機會 |

|---|---|---|

| 訓練階段 | 收集資料、處理資料、訓練模型、驗證效能 | 污染訓練資料、植入後門 |

| 推論階段 | 模型已部署,接受查詢並輸出結果 | 製作對抗樣本、竊取模型 |

攻擊者可能在任一階段發動攻擊,因此兩個階段都需要安全防護。

2. AI 存取點(AI Access Points)

攻擊者與 AI 系統互動的方式有兩種:

- 數位存取點:最常見的是 API 存取,攻擊者透過發送查詢並觀察回應來與模型互動

- 實體存取點:攻擊者在現實世界中修改 AI 會收集的資料,例如在路標上貼特殊貼紙來干擾自駕車的視覺系統

3. 系統知識(System Knowledge)

攻擊者對 AI 系統了解的程度,決定了他們能發動什麼樣的攻擊:

| 知識程度 | 說明 | 攻擊難度 |

|---|---|---|

| 白箱(White-box) | 攻擊者知道模型架構、權重、訓練資料 | 較容易發動精準攻擊 |

| 黑箱(Black-box) | 攻擊者只能透過輸入輸出與模型互動 | 需要更多嘗試,但仍然可行 |

重要的是,即使在黑箱情境下,攻擊者仍然可以透過大量查詢來推測模型的行為,並發動有效攻擊。

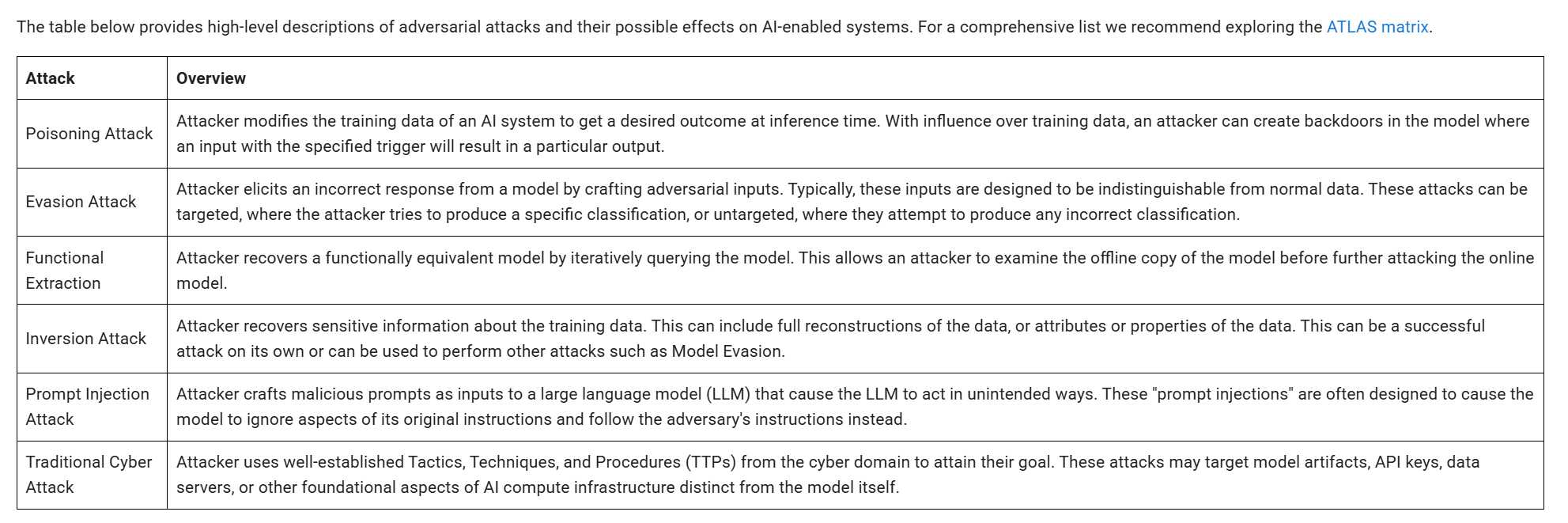

六大常見 AI 攻擊類型

1. 投毒攻擊(Poisoning Attack)

攻擊原理:攻擊者在訓練階段污染訓練資料,讓模型學到錯誤的行為。

攻擊效果:

– 模型在特定情況下做出錯誤判斷

– 在模型中植入「後門」,當輸入包含特定觸發條件時產生預設的錯誤輸出

真實案例情境:

想像一個垃圾郵件過濾器,攻擊者在訓練資料中加入大量標記為「正常」的垃圾郵件,導致模型上線後無法正確辨識這類垃圾郵件。

防禦要點:

– 嚴格管控訓練資料來源

– 驗證訓練資料的完整性

– 監控模型行為是否出現異常

2. 規避攻擊(Evasion Attack)

攻擊原理:攻擊者在推論階段製作特殊的「對抗樣本」(Adversarial Examples),這些輸入對人類來說看起來正常,但會讓 AI 做出錯誤判斷。

攻擊類型:

– 目標式攻擊:讓 AI 輸出攻擊者指定的特定結果

– 非目標式攻擊:讓 AI 輸出任何錯誤結果

真實案例情境:

研究人員發現,在眼鏡框上加上特殊圖案,可以讓人臉辨識系統將一個人誤認為另一個人。在停止標誌上貼上特定貼紙,可以讓自駕車的視覺系統將其誤判為速限標誌。

防禦要點:

– 使用對抗訓練強化模型韌性

– 部署輸入驗證機制

– 實施多重驗證機制

3. 功能提取攻擊(Functional Extraction)

攻擊原理:攻擊者透過大量查詢目標模型,觀察輸入與輸出的對應關係,逐步建立一個功能相似的「替代模型」。

攻擊目的:

– 竊取模型的智慧財產

– 在離線環境研究模型弱點,再攻擊線上模型

– 規避按查詢次數計費的商業模式

真實案例情境:

攻擊者對某公司的圖片分類 API 發送數萬次查詢,收集足夠的輸入輸出配對後,訓練出一個功能相近的模型,不需付費就能使用類似功能。

防禦要點:

– 限制 API 查詢頻率

– 監控異常查詢模式

– 在輸出中加入擾動

4. 反向攻擊(Inversion Attack)

攻擊原理:攻擊者透過分析模型的輸出,反推出訓練資料中的敏感資訊。

洩漏內容可能包括:

– 訓練資料的完整重建

– 資料的屬性或特徵

– 個人隱私資訊

真實案例情境:

研究人員證明,可以從人臉辨識模型中反推出訓練時使用的人臉照片。這意味著即使原始訓練資料已經刪除,隱私仍然可能透過模型洩漏。

防禦要點:

– 使用差分隱私技術

– 限制模型輸出的詳細程度

– 定期審計模型的隱私風險

5. 提示注入攻擊(Prompt Injection Attack)

攻擊原理:針對大型語言模型(LLM),攻擊者製作惡意提示詞,讓模型忽略原本的指令,轉而執行攻擊者的指令。

攻擊類型:

– 直接注入:使用者直接輸入惡意提示詞

– 間接注入:惡意指令藏在模型會讀取的外部資料中(如網頁、文件)

真實案例情境:

攻擊者在網頁中隱藏特殊指令,當 LLM 應用程式讀取該網頁進行摘要時,就會執行隱藏的指令,例如洩漏使用者的對話紀錄或引導使用者前往惡意網站。

防禦要點:

– 嚴格區分系統指令與使用者輸入

– 對外部資料來源進行過濾

– 限制 LLM 的權限範圍

6. 傳統網路攻擊(Traditional Cyber Attack)

攻擊原理:使用傳統的網路攻擊手法,針對 AI 系統的基礎設施發動攻擊。

攻擊目標可能包括:

– 模型檔案本身

– API 金鑰

– 資料伺服器

– AI 運算基礎設施

重要提醒:

AI 系統不只需要防禦 AI 專屬的攻擊,傳統的資安威脅同樣適用。許多 AI 系統的漏洞其實來自基礎設施的安全疏失,而非 AI 本身的問題。

防禦要點:

– 落實傳統資安最佳實踐

– 保護模型檔案與 API 金鑰

– 實施存取控制與監控

AI 生命週期中的安全考量

要有效防禦 AI 攻擊,必須在整個開發生命週期中融入安全思維。MITRE ATLAS 採用 CRISP-ML(Q) 框架來定義 AI 開發的六個階段:

階段一:業務與資料理解

在這個階段,團隊需要了解業務需求並評估可用資料。安全考量包括評估資料來源的可信度,以及識別潛在的隱私風險。

階段二:資料工程

準備和處理訓練資料。安全考量包括驗證資料完整性、防止資料被污染,以及確保資料處理流程的安全。

階段三:模型工程

設計和訓練 AI 模型。安全考量包括選擇具有安全特性的模型架構、實施對抗訓練,以及保護訓練環境。

階段四:品質保證

驗證模型的效能和可靠性。安全考量包括測試模型對對抗樣本的韌性,以及評估模型是否存在後門。

階段五:部署

將模型部署到生產環境。安全考量包括保護 API 端點、實施存取控制,以及設置監控機制。

階段六:監控與維護

持續監控模型表現並進行更新。安全考量包括偵測異常行為、識別可能的攻擊,以及定期重新評估安全風險。

AI 安全的新興領域

LLM 安全

大型語言模型(如 ChatGPT)帶來了獨特的安全挑戰:

– 龐大的訓練資料集難以完全審查

– 模型內部運作不透明

– 自然語言輸入難以過濾惡意內容

主要威脅包括提示注入、外掛程式漏洞、越獄攻擊等。

硬體安全

AI 系統的硬體層面也存在安全風險:

– 側通道攻擊:從電壓測量或回應時間推測系統資訊

– 故障注入攻擊:透過錯誤輸入或環境干擾破壞系統

– 硬體木馬攻擊:在 GPU 或其他硬體中植入後門

自主系統安全

自駕車、無人機等自主系統結合了 AI 與實體世界的互動,攻擊面更加複雜。攻擊者可能透過干擾感測器或操控環境來影響系統決策。

AI 的惡意使用

攻擊者也開始利用 AI 來強化傳統網路攻擊:

– AI 輔助的偵察與漏洞掃描

– 自動化的攻擊開發

– 個人化的釣魚與社交工程

– 針對關鍵基礎設施的智慧攻擊

政策與法規發展

隨著 AI 安全議題受到重視,各國政府和國際組織也開始制定相關規範:

| 發布單位 | 文件名稱 |

|---|---|

| NIST | AI 風險管理框架 |

| 英國國家網路安全中心 | 安全 AI 系統開發指南 |

| 歐盟 | 人工智慧法案(EU AI Act) |

| 世界衛生組織 | 健康領域 AI 倫理與治理 |

這些政策框架為組織提供了 AI 安全的最佳實踐指引。

如何開始學習 AI 安全?

- 熟悉 MITRE ATLAS 框架:瀏覽 atlas.mitre.org 了解完整的攻擊技術分類

-

閱讀真實案例:ATLAS 收錄的 42 個案例研究是最好的學習素材

-

動手實驗:使用開源工具如 CALDERA 進行威脅模擬

-

加入社群:透過 ATLAS Slack(mitreatlas.slack.com)與全球 AI 安全社群交流

-

持續學習:AI 安全是快速演進的領域,定期關注最新研究和案例

結語

AI 安全不是一個可以「解決」的問題,而是一個需要持續關注的領域。隨著 AI 技術的演進,新的攻擊手法會不斷出現,防禦策略也需要與時俱進。

無論你是 AI 開發者、資安專業人員,還是決策者,了解 AI 安全的基礎知識都是在這個 AI 時代保護組織和使用者的必要準備。

希望這篇文章能幫助你建立對 AI 安全的初步認識。如果想深入了解特定主題,歡迎繼續閱讀我們的系列文章,或前往 MITRE ATLAS 官方網站探索更多內容。

參考資源

- MITRE ATLAS 官方網站:atlas.mitre.org

- MITRE ATLAS AI Security 101:atlas.mitre.org/resources/ai-security-101

- CRISP-ML(Q) 框架:ML-Ops.org

- NIST AI 風險管理框架:nist.gov/itl/ai-risk-management-framework